Les tests A/B trompeurs sont simples

par Rostyslav Mykhajliw Fondateur de TrueSocialMetrics.com ~ 5 min

Classique

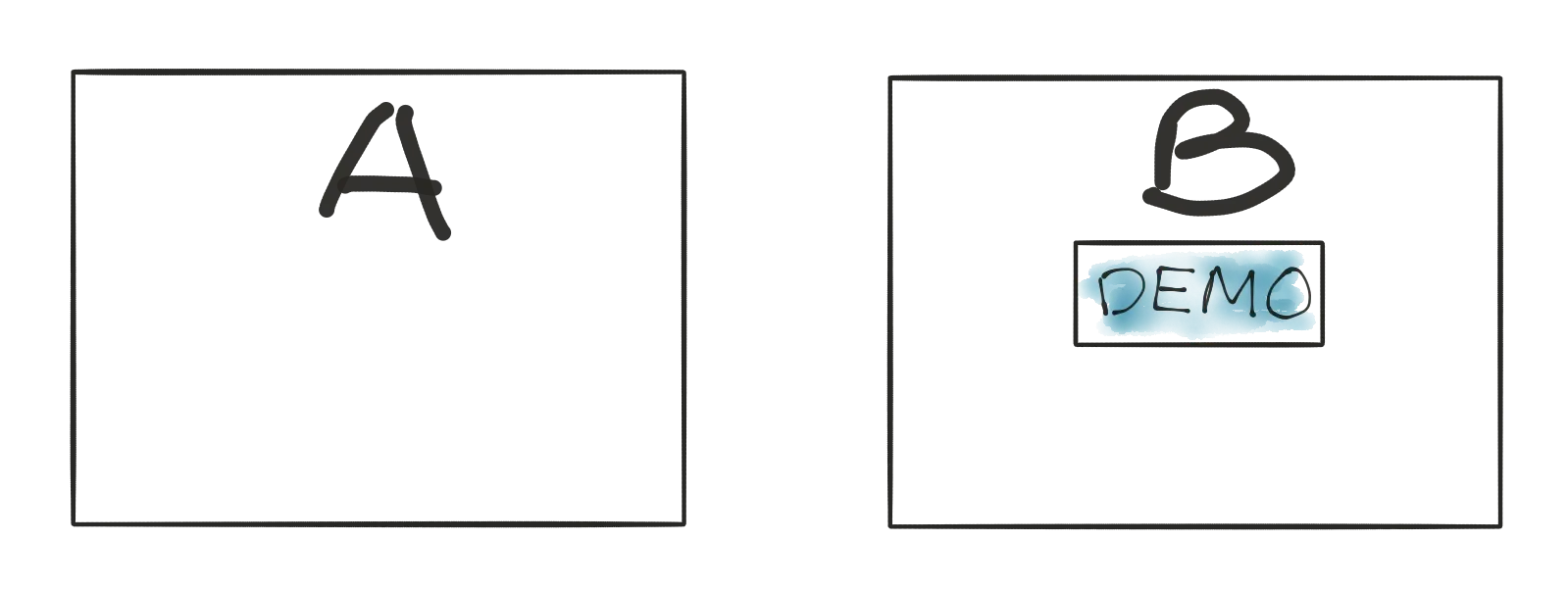

Le test A/B classique est une répartition entre différents états. Commençons par un échantillon général que tout le monde utilise. Nous avons un site avec un bouton d'inscription, actuellement il est bleu, mais nous voulons tester une nouvelle couleur rouge.

Ensuite, nous y allouons du trafic et en attendons quelques-uns. Il existe une calculatrice simple pour statistical significance.

Option A : 50 000 visites - 500 inscriptions Options B : 50 000 visiteurs - 570 inscriptions - gagnant

B est un gagnant, c'est un clair. Plus d'inscriptions, signification statistique.

Un nouveau classique de la pomme aux oranges

Attends un peu! Ce que nous publions quelque chose de nouveau. Par exemple, nous ajoutons un bouton "démo" pour un aperçu du guide étape par étape à travers le produit.

Si nous suivons une logique simple de tests A/B - ça ne marche pas ! Parce qu'on ne peut pas comparer des pommes à des oranges. On ne peut pas comparer rien à quelque chose ! C'est totalement faux. S'il n'y a pas de bouton de démonstration, les utilisateurs peuvent avoir une expérience pire que ceux qui ont cette option. Mais cette option ne peut aider que les utilisateurs qui sont déjà intéressés par le produit ou qui ont déjà déclaré utiliser le produit récemment. Même si vous avez des millions de trafic, vous ne pouvez pas dire comment cela fonctionne en quelques heures/jours car les résultats peuvent être différés dans le temps.

Pour qu'une nouvelle fonctionnalité soit libérée linéairement comme processus de libération entérale. Ce n'est qu'alors qu'après un certain temps, nous pourrons l'examiner et déterminer si cela a eu un impact sur l'expérience client ou non, mais en suivant les mesures commerciales. Les tests A/B ne sont PAS applicables pour une nouvelle fonctionnalité.

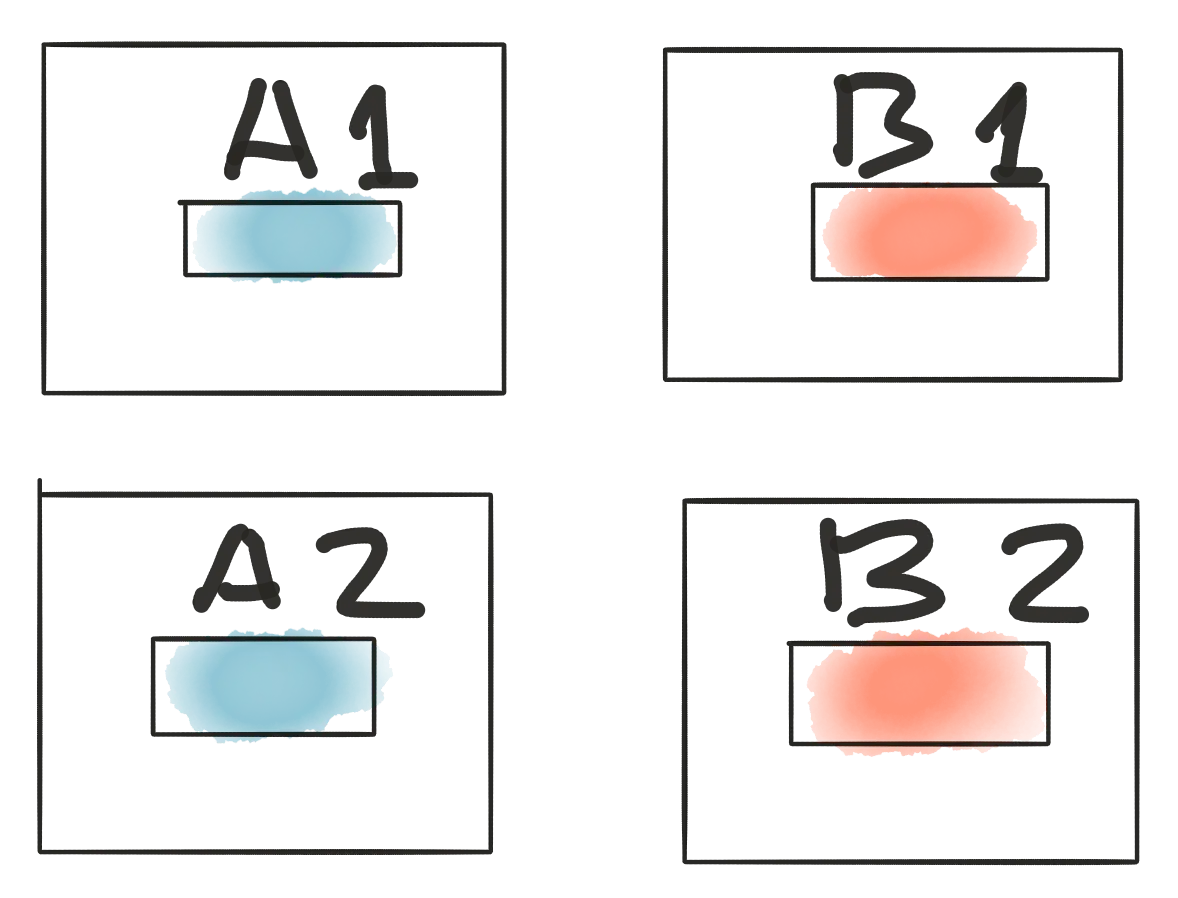

AA/BB teste la confiance

Revenez au premier échantillon avec le bouton d'inscription. Si notre supposition est correcte, nous pouvons ajouter plus d'options A et plus d'options B et rien ne change, car B peut toujours gagner la bataille.

Regardez ensuite les résultats :

A1 : 50 000 visites - 500 inscriptions A2 : 50 000 visiteurs - 580 inscriptions - gagnant B1 : 50 000 visiteurs - 570 inscriptions - gagnant B2 : 50 000 visiteurs - 500 inscriptions

QUOI! QUOI! QUOI! Vous pouvez dire que c'est impossible, mais cette situation montre une différence si l'attribution des visiteurs prend effet sur les résultats des tests. Et ces résultats montrent une signification statistique stable à 95 %, mais une confiance faible.

Tests adaptatifs

Si nous revenons au début de l'article, nous remarquerons un énorme trafic de 50 000 visiteurs et 500 transitions nécessaires pour recevoir des résultats significatifs. Cependant toutes les pages n'ont pas ces possibilités. Toutes les startups ne sont pas assez bonnes pour générer un tel trafic, ou il peut s'agir de pages à faible trafic comme les paramètres/facturation, etc. ou alors. Le prochain inconvénient de l'approche générale est qu'au moins 50 000 visiteurs (sur 100 000 alloués au test) ont vu leur expérience client se détériorer. Nous attendons donc depuis longtemps et perdons des clients en raison de l'attribution à un test "perdant". Celà a-t-il un sens ? Dans les soins de santé, les médecins ont traversé les problèmes de cas, mais dans un tableau, il y avait la vie des gens. Si nous faisons un test pendant lequel 50 % des patients meurent à cause de "soins non encore testés". Et c'est fou. Voici un gars, Marvin Zelen, qui a eu l'idée des tests adaptatifs, appelé maintenant Zelen’s design.

En bref

Imaginons que nous ayons 2 possibilités : des boules rouges et bleues, donc statistiquement c'est 50 % de probabilité.

Par exemple, nous attribuons au hasard le visiteur au « bleu » et « le bleu » est une meilleure expérience car nous avons obtenu un achat. Dans ce cas, "bleu" est gagnant, c'est pourquoi nous ajoutons une boule "bleue" supplémentaire à la piscine.

Lorsque la probabilité de résultat a changé "rouge" - 33 % et "bleu" - 67 %

Ça a l'air bien! Mais le prochain visiteur avec "bleu" ne fait rien. Donc "bleu" perd, c'est pourquoi nous devons retirer une balle "bleue" de la piscine et nous avons retrouvé notre état précédent.

Avantages : + fonctionne pour une petite quantité de trafic + fournit de manière adaptative une meilleure prise en charge des utilisateurs Moins : - nécessite que les développeurs travaillent pour comprendre les tests gagnants/perdants au cours du processus de test

Commotions cérébrales

- Les tests A/B classiques ne fonctionnent pas pour une nouvelle fonctionnalité car vous ne pouvez rien tester avec quelque chose

- Généralement, les tests A/B ne sont PAS représentatifs même si vos analyses indiquent qu'ils le sont

- L'approche AA/BB aide à vérifier les résultats des tests A/B

- Les tests adaptatifs sont très utiles pour les petits trafics, mais nécessitent un travail manuel pour déterminer les objectifs

Lorsque vous êtes prêt à faire vibrer vos analyses de médias sociaux

essayez TrueSocialMetrics!

Commencer procès

Pas de carte de crédit nécessaire.